Algoritmos preconceituosos? Entenda a relação entre inteligência artificial e os códigos racistas

Por Talita Souza

A internet surgiu para mudar paradigmas, romper preconceitos e promover a evolução social, certo? Enquanto a inteligência artificial depender da inteligência humana, não necessariamente. Pelo contrário: programas, mecanismos de pesquisa e algoritmos tendem a reproduzir preconceitos do mundo real.

“O meio virtual é um reflexo do que acontece na esfera social presencial. A internet acaba sendo um lugar de discursos de ódio, pensamentos e ideias preconceituosas e opiniões extremamente conservadoras.”

A afirmação é de Denise Carvalho, doutora em Sociologia pela Universidade de São Paulo (USP) e autora de um artigo que analisa “algoritmos racistas” em bancos de imagens digitais. Para comprovar essa opinião, basta lembrar que a rede social mais popular do mundo, o Facebook, com mais de 1 bilhão de usuários, surgiu em 2004 como um site de relacionamento que permitia o julgamento e comparação entre mulheres da Universidade Harvard. Desde então, a popularização do acesso à internet e às redes sociais gerou debates sobre questões como essa nas próprias plataformas.

O problema, no entanto, está na sociedade e não nos códigos. Quem confirma isso é Altair Santin, professor no programa de pós-graduação em Informática da PUCPR. “A base da inteligência artificial (IA) é fazer um computador desenvolver a capacidade de pensar e funcionar como o ser humano. Se o indivíduo tem preconceitos, os códigos vão refletir isso”, explica.

A discussão em torno dos chamados “preconceitos algoritmos” não é nova. Em 2016, um vídeo que atingiu milhares de compartilhamentos no Twitter mostra a pesquisa “three black teenagers” (três adolescentes negros) no Google Imagens, que resulta em fotos de fichas policiais de jovens afrodescendentes. Em contrapartida, ao procurar por ”adolescentes brancos”, o resultado são registros de pessoas felizes, interagindo e praticando esportes.

A rede de buscas voltou a essa discussão no fim de 2018, quando lançou o BERT, um sistema de inteligência artificial que aprende a partir de informações digitalizadas com a intenção de se adaptar à forma com que as pessoas escrevem e falam. O problema é que a associação de informações dos materiais de origem também pode absorver preconceitos.

No caso do BERT, informações sobre homens são priorizadas diante daquelas sobre as mulheres. Em um artigo publicado por cientistas da computação da Universidade Carnegie Mellon, o sistema demonstrou maior probabilidade de associar a palavra “programador” a homens, por exemplo.

Preconceitos como esses, entretanto, só são descobertos e superados à medida que a inteligência é usada e aperfeiçoada. Segundo Santin, “os programas trabalham em favor das pessoas. Conforme a demanda de busca delas muda, os algoritmos vão sendo refinados.” Ou seja, se nas buscas palavras positivas forem associadas a grupos minoritários, por exemplo, as plataformas vão passar a priorizar conteúdos parecidos.

Já para a cientista social Denise Carvalho, o caminho não pode ser outro além da educação. A pesquisadora de fende a necessidade de “fazer com que os indivíduos compreendam que o que nós vivemos hoje é consequência de um passado de ideais preconceituosos e discriminatórios.”

Mais recentemente, em setembro de 2020, uma discussão semelhante foi iniciada no Twitter. O usuário @bascule publicou um tuíte com duas imagens, ambas com fotos do senador americano Mitch McConnell e do ex-presidente Barack Obama em posições invertidas. Nos dois casos, a foto do senador, um homem branco, foi priorizada como destaque para a visualização.

A empresa e sua representante no Brasil se pronunciaram em publicações na rede. “Fizemos uma série de testes antes de lançar o modelo e não encontramos evidências de preconceito racial ou de gênero. Está claro que temos mais análises a fazer. Continuaremos compartilhando nossos aprendizados e medidas e abriremos o código para que outros possam revisá-lo.”

Futuro perigoso

Com o futuro da tecnologia voltado para o desenvolvimento de softwares independentes, capazes de tomar decisões automatizadas, essas programações podem significar “riscos significativos para os direitos e liberdades das pessoas que necessitam de garantias apropriadas”. A declaração está presente no último relatório do AI Now, instituto de Nova York dedicado a pesquisar as implicações sociais da inteligência artificial.

Mudança de perspectiva

Há quem já esteja trabalhando para reverter esse cenário. É o caso de Levis Novaes, fundador do MOOC (Movimento Observador Criativo), uma agência de criatividade que “surgiu dessa insatisfação de não se enxergar nas mídias”, de acordo com o próprio Levis. Criada em 2015 por oito publicitários, todos negros, entre mulheres, homens e representantes do movimento LGBTQIA+, o MOOC já produziu trabalhos para grandes marcas globais. Entre os mais representativos, está uma campanha da La Roche-Posay com o objetivo de reforçar o protagonismo negro e a diversidade de gênero no Facebook incluindo personagens negros nas peças veículadas.

O trabalho faz parte da proposta de retratar grupos minoritários sem um olhar estereotipado, como nos conteúdos geralmente encontrados na internet. Isso só é possível por conta valorização de um quadro de funcionários diverso. “Uma das coisas mais ricas da MOOC é essa diversidade na curadoria das pessoas que são ouvidas e exercem todo o potencial que elas podem alcançar”, acrescenta o publicitário.

“Por um lado, havia elitismo e manutenção de privilégios e com o passar do tempo a MOOC foi percebendo que existia essa oportunidade de fazer as coisas de uma forma diferente.” O resultado apontado por Levis é uma mudança de paradigma na estética e no mercado: a representatividade trazida pelas campanhas atende um grupo com potencial de consumo que sempre existiu, mas nunca foi percebido.”

Tecnologias do bem

Anunciado no dia 8 de abril deste ano, um banco de dados do Facebook promete auxiliar programadores a desenvolverem ferramentas que funcionem para pessoas de todas as idades, sexos e tons de pele. Os profissionais têm acesso a informações de código aberto (disponíveis para download) de 3.011 residentes dos Estados Unidos.

O Casual Conversations “(conversas casuais)” recebeu esse nome pois foram gravados vídeos dos participantes enquanto eles respondiam a perguntas aleatórias. Ao mesmo tempo, foram colhidos dados da sua aparência em diferentes condições de iluminação. Na Universidade de Virgínia, criaram, em fevereiro, um sistema capaz de identificar reações racistas. Ele foi feito a partir da detecção de expressões apresentadas por 76 voluntários ao olharem imagens e palavras associadas a expressões como “pele escura”, “pele clara”, “má” e “boa”. 76,1% deles apresentaram um viés de racismo implícito.

Algumas iniciativas no sentido contrário dão esperança de um futuro mais diverso nos conteúdos encontrados na internet. É o caso do Nappy, um banco de imagens totalmente gratuito apenas com fotos de pessoas negras, idealizado por uma agência de criadores negros do Brooklyn, em Nova York.

Já o Young, Gifted and Black, ou YGB, é criado por mulheres negras, da produção à programação do site. O nome é o mesmo de uma música da cantora Nina Simone, que virou símbolo na luta por direitos civis americanos.

Para entender melhor o tema

CODED BIAS – 2020: Didático, demonstra, a partir de uma pesquisa feita pela acadêmica negra Joy Buolamwini, do MIT, como sistemas de reconhecimento facial podem discriminar pessoas por conta do tom de pele. Para isso, ela testa a tecnologia com seu próprio rosto e com uma máscara branca. Disponível na Netflix.

O DILEMA DAS REDES – 2020: O documentário foi um dos mais comentados em seu ano de lançamento. Nele, profissionais do Vale do Silício – berço de grandes marcas de tecnologia, como Apple, Facebook e Google – são convidados a discutir a influência das redes sociais nas ações e relações humanas. Disponível na Netflix.

A REDE SOCIAL – 2010: O longa retrata a criação do Facebook por Mark Zuckerberg em 2003, na época um estudante de Harvard e hoje considerado um gênio da computação e um dos maiores nomes da tecnologia. Disponível no YouTube.

BLACK MIRROR – 2011: Contos fictícios trazem debates reais à tona sobre as implicações das tecnologias. A série virou até meme por, teoricamente, prever o caos pelo qual o mundo passaria em eventos como a pandemia de coronavírus. Disponível na Netflix.

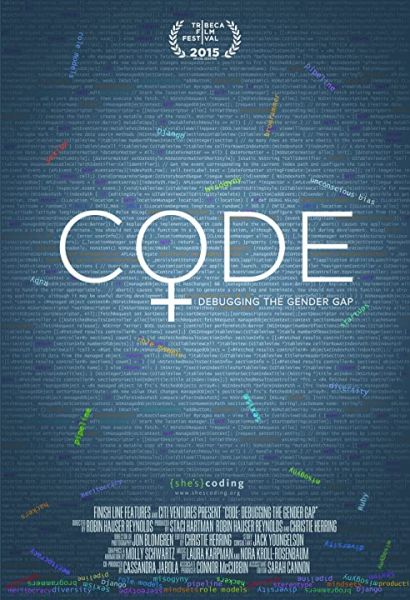

MULHERES HTML – 2016: Como a falta de engenheiras de software reflete na exclusão de mulheres no ambiente digital? Essa é a discussão proposta no documentário, que também apresenta revoluções feitas pelas profissionais do setor. Disponível em inglês no Amazon Prime, com o título Code: Debugging the Gender Gap.

*Matéria originalmente publicada na edição #250 da revista TOPVIEW.